研究发现聊天机器人无法胜任多语言医疗顾问的工作

佐治亚理工学院的研究人员表示,非英语人士不应该依赖 ChatGPT 等聊天机器人来提供有价值的医疗保健建议。

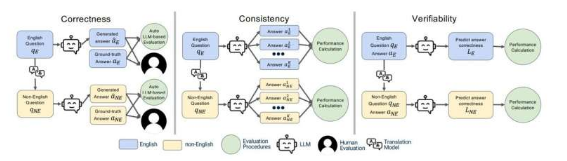

佐治亚理工学院计算机学院的一组研究人员开发了一个用于评估大型语言模型 (LLM) 能力的框架。博士生 Mohit Chandra 和 Yiqiao (Ahren) Jin 是论文《最好用英语提问:跨语言评估用于医疗保健查询的大型语言模型》的共同主要作者。该论文发表在arXiv预印本服务器上。

他们的论文研究结果揭示了法学硕士与回答健康相关问题的能力之间存在差距。Chandra 和 Jin 指出了法学硕士对用户和开发者的局限性,但也强调了其潜力。

他们的 XLingEval 框架告诫非英语人士不要使用聊天机器人代替医生寻求建议。不过,通过使用多语言源材料(例如他们提出的 XLingHealth 基准)深化数据库,模型可以得到改进。

金表示:“对于用户来说,我们的研究支持了 ChatGPT 网站已经指出的观点:聊天机器人会犯很多错误,所以我们不应该依赖它们进行关键决策或获取需要高精度的信息。”佐治亚理工学院的研究人员表示,非英语人士不应该依赖 ChatGPT 等聊天机器人来提供有价值的医疗保健建议。

佐治亚理工学院计算机学院的一组研究人员开发了一个用于评估大型语言模型 (LLM) 能力的框架。博士生 Mohit Chandra 和 Yiqiao (Ahren) Jin 是论文《最好用英语提问:跨语言评估用于医疗保健查询的大型语言模型》的共同主要作者。该论文发表在arXiv预印本服务器上。

他们的论文研究结果揭示了法学硕士与回答健康相关问题的能力之间存在差距。Chandra 和 Jin 指出了法学硕士对用户和开发者的局限性,但也强调了其潜力。

他们的 XLingEval 框架告诫非英语人士不要使用聊天机器人代替医生寻求建议。不过,通过使用多语言源材料(例如他们提出的 XLingHealth 基准)深化数据库,模型可以得到改进。

金表示:“对于用户来说,我们的研究支持了 ChatGPT 网站已经指出的观点:聊天机器人会犯很多错误,所以我们不应该依赖它们进行关键决策或获取需要高精度的信息。”

免责声明:本答案或内容为用户上传,不代表本网观点。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,请读者仅作参考,并请自行核实相关内容。 如遇侵权请及时联系本站删除。